V 18. století kosily námořníky kurděje. Padlo jim za oběť víc námořníků než na válečná zranění. Kapitán Cook doporučoval slad a kysané zelí.

Další tutové recepty byly:

- vitriol (zředěná kyselina sírová),

- pouštění žilou (na což umřel americký prezident George Washington),

- kus trávníku pod jazyk.

Překvapivě pomáhalo pojídání lodních krys, které si jsou schopné samy tvořit vitamín C. Cestovatel Sir Richard Hawkins doporučoval už v roce 1622 kyselé citróny a pomeranče a povzdechl si, že by bylo fajn, aby „o tom napsal někdo učený.“

Což se stalo, ale až o století později. Chopil se toho James Lind. Ten se v 1730 přihlásil k námořnictvu jako chirurg, a tak mohl pozorovat kurděje z první ruky.

V roce 1747 provedl na palubě HMS Salisbury jednu z prvních kontrolovaných klinických studií zaznamenaných v lékařské vědě.

Vzal 12 mužů, rozdělil je do 6 skupin po dvou a každé skupině dával něco jiného.

- litr cideru

- 25 kapek vitriolu 3krát denně

- čtvrt litru mořské vody

- pasta z česneku, hořčice, ředkvičky, balzám z Peru a myrhu

- 2 lžíce octa 3krát denně

- dva pomeranče a jeden citrón každý den.

Za týden pomáhala šestá skupina léčit zbytek testovaných. V roce 1753 o tom napsal pojednání.

Ale až za 42 let – a rok po smrti doktora Linda – to začala admiralita doporučovat oficiálně námořníkům. Prý proto, že doporučení z pojednání nebylo jednoznačné a o citrusech se psalo na 4 stránkách ze 450.

Bylo to vlastně takové A/B/C/D/E/F/G testování. Jedna kontrolní skupina a pak 6 variant léčení.

Co je A/B testování

A/B testování je metoda, kdy porovnáváte dvě (případně více) verze webové stránky nebo aplikace a zjišťujete, která lépe plní cíl nebo cíle. Je to v podstatě experiment, ve kterém uživatelům náhodně ukazujete jednu nebo druhou variantu a na základě statistiky zjišťujete, která lépe funguje.

Výhoda je v tom, že od pocitů přejdete k důkazům a vidíte, o kolik je daná verze lepší (nebo horší).

Kdy netestovat

Pokud máte méně než 1000 konverzí za měsíc, tak o A/B testování ani neuvažujte. I v případě, že máte 1000 konverzí, tak budou testované verze muset být rozdílné o minimálně 15 %, aby to bylo statisticky jisté. A nebudete moct udělat víc než 20 testů ročně.

Ono A/B testování taky není svatý grál. Jednak i bez něj dokážete web výrazně zlepšit, jednak je tam dost pastí, které vás můžou potkat a výsledky jsou potom jen iluze.

Nicméně jsem sobě, a vám, chtěl udělat takový checklist, na co nezapomenout. Berte to jako takové work-in-progress noty a kompilát vlastních zkušeností a studií z Microsoftu, Netflixu, Amazonu, Bookingu, AirBnB a dalších.

Checklist

Pokud zvládnete tohle, 80 % vašich experimentů bude v pohodě (zbytek tipů si probereme jindy, i tak to bude dost technické).

- Vyberte si metriku (Overall Evaluation Criteria), kterou chcete zlepšit

- Předem si naplánujte, co uděláte, pokud bude výsledek pozitivní, negativní, nebo neurčitý

- Vytvořte si hypotézu

- Zvolte si cílení na uživatele

- Spočtěte si minimální zjistitelný efekt, nutnou návštěvnost, a délku testu

- Zjistěte si, jak dlouhý je byznys cyklus

- Nechte běžet test po celou spočítanou dobu, teprve pak ho vyhodnoťte

- Zezačátku testujte jen stávající a novou verzi

- Pokud vypadají výsledky příliš dobře, jsou špatně

- Nezastavujte variantu v průběhu testu a neměňte poměr návštěvnosti

1. Vyberte si metriku (Overall Evaluation Criteria)

Je důležité vědět, co chcete zlepšit. Když se ptám poprvé zákazníků, tak většinou říkají:

- konverzní poměr,

- obrat.

Pokud vám jde jen o konverzní poměr, tak vypněte PPCčka a dejte dopravu na vše zadarmo. Konverzní poměr se tím určitě zlepší. Což se ale nedá říct o stavu firemního bankovního konta.

Obrat už je trochu lepší, ale i tady vám řeknu, škrtněte si marži / zlevněte o 20 % a prodávejte za náklady nebo pod ně. Obrat bude větší, protože budete pravděpodobně nejlevnější. A taky brzy v insolvenci.

Podle Roniho Kohaviho z Microsoftu je ideální metrika taková, která vám zvyšuje lifetime value uživatele. Často je to vážená kombinace prodaných kusů, obratu, zisku, a celkové hodnoty zákazníka (LTV).

Protože jinak zákonitě uslyšíte: „… ale zlepšil se nám čas na stránce / snížila bounce rate / další nepodstatná metrika.“

2. Předem si naplánujte, co uděláte, pokud bude výsledek pozitivní, negativní, nebo neurčitý

Nová verze vyhrála? Super. Nová verze nevyhrála? Nebo to nedošlo do statistické jistoty / síly?

Na papíře to vypadá jednoduše:

- B verze vyhrála – nasadit

- B verze prohrála – nechat původní a otestovat jinou variantu / spustit jiný test.

Ale co když B verze vyhrála, ale mobil se snížil o 20 % a desktop zvýšil o 30 %. Nasadíte to? Nebo co když je statisticky jistá sekundární metrika jako proklik do dalšího kroku, ale už ne hlavní metrika.

Pokud si tohle neřeknete předem, tak riskujete, že budete trpět kognitivním zkreslením.

3. Vytvořte si hypotézu

Pro testování musíte mít solidní hypotézu. Něco, co se dá:

- změřit,

- vyvrátit (nebo potvrdit).

A taky něco, co vychází z dat a nevycucali jste si to z prstu. Ideálně si tím ověřujete něco, co jste zjistili jinými metodami výzkumu. Což může být cokoliv od analytiky po konzultaci s call centrem.

Hypotéza je prohlášení o tom, co dnes považujete za pravdivé.

Mustr na hypotézu je:

Na základě dat z A a zpětné vazby B si myslíme, že když uděláme C pro cílové zákazníky D, tak se stane E. Zjistíme, zda to byla pravda tím, že v datech uvidíme F a dostaneme zpětnou vazbu G. Předpokládáme, že se změní metrika H o I v rámci J byznys cyklů.

Příklad hypotézy: Z heatmap jsme zjistili, že lidi v košíku klikají na menu. Ale při segmentaci tito lidé nenakupují další produkty a odcházejí. Tím, že vyhodíme navigaci v košíku, dáme lidem méně možností a víc lidí dokončí objednávku.

4. Zvolte si cílení na uživatele

Koho chcete otestovat? Lidi na desktopech, na mobilech. Zákazníky, přihlášené uživatele, lidi co navštívili stránku kontakt nebo posloupnost stránek?

A je možné z testu vyloučit část uživatelů, která je pro test nerelevantní?

Chcete zjistit něco o určitém typu uživatelů. Čím méně budete tento vzorek „znečišťovat“, tím přesnější budete mít výsledek. A taky rychlejší.

Já například doporučuji netestovat dohromady mobil a desktop, lidi se chovají různě a weby taky vypadají odlišně.

5. Spočtěte si minimální zjistitelný efekt, nutnou návštěvnost, a délku testu

Většina práce vás bude čekat před samotným spuštěním A/B testu. Po samotném spuštění testu už jen budete kontrolovat, zda vše běží v pořádku a pak výsledek po spočítané době (případně v intervalech při sekvenčním testování).

Co potřebujete vědět pro výpočet?

- návštěvnost testované stránky

- počet konverzí (pro uživatele kteří viděli testovanou stránku)

- počet variant (až na výjimky 2 – stávající a novou)

A co si spočítáte?

- Nutnou návštěvnost na variantu – kolik lidí musí vidět každou variantu.

- Jak dlouho vám poběží test – pokud je to víc než 6-8 týdnů, tak je to nešikovné (kvůli sample polution).

- Minimální detekovatelný efekt – o kolik to musí být lepší, aby výsledek nebyl náhoda.

Mám na to oblíbené kalkulačky od CXL, AB Tasty a AB Test Guide.

6. Zjistěte si, jak dlouhý je byznys cyklus

Schválně se podívejte, jak se vám mění konverzní poměr mezi jednotlivými dny. U většiny mých klientů to „lítá“ plus minus dvacet procent. A nedej bože, že je někde státní svátek.

I proto doporučuji jako minimum brát 2 týdny. V takovémto období se už většina odchylek zploští. Co se týče maximální doby, tam to hodně záleží na produktu. Čím je dražší a složitější, tím delší čas potřebují lidi na rozhodnutí o koupi.

Já teď například pomáhám s magnetorezonancí, a tam to moc impulzivní a rychlé rozhodnutí není.

7. Nechte běžet test po celou spočítanou dobu, teprve pak ho vyhodnoťte

Častá chyba – kterou jsem taky dělal – je ukončit test, jakmile dojde do statistické jistoty. Problém je ale v tom, že výsledek kolem statistické jistoty osciluje a to, že jednou vidíme jistotu nad 95 % neznamená, že zítra ji tam uvidíme taky.

Když dělali 1000 tzv. A/A testů (test stejných verzí), tak zjistili, že v nějakou chvíli dosáhlo statistické jistoty 53 % z nich. Jinými slovy ve většině testů stejných verzí vám v nějakou chvíli test ukazuje jistotu 95 %, že jedna verze je lepší než druhá.

Chci tím říct, že fakticky spouštíte test s pevným časovým horizontem. Tím, že na to budete čumět každý den s prstem na tlačítku si zvýšíte šanci, že uděláte špatné rozhodnutí 5násobně.

Pokud si vezmu příklad, kdy máte 2000 uživatelů. V A variantě se podíváte až na konci testu (a míříte na 90% jistotu). Ve B variantě to budete kontrolovat po každé návštěvě. Čímž si zvýšíte šanci zvolit špatně 5násobně (a máte jen 45% jistotu, že zvolíte správně). Zde je k tomu detailní článek.

8. Zezačátku testujte jen stávající a novou verzi

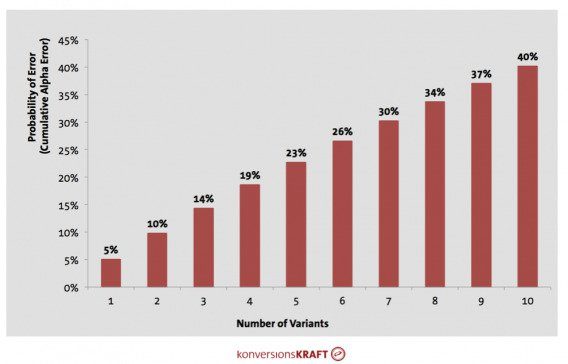

Čím víc variant budete testovat, tím větší budete mít šanci, že zvolíte špatnou. Odborně se tomu říká kumulativní alfa chyba. Přeloženo do češtiny to znamená, že šance, že zvolíte špatně se sčítá. Takže pokud si u 2 variant dovolíte chybovost 1 ku 20, tak u deseti testovaných variantách už je chybovost (při 95 % jistotě) nad 40 %.

Většina testovacích nástrojů už má v sobě zabudovanou korekci (Bonferroni, Dunnett, Šidák atd.).

Začněte jednoduše, a postupně můžete přidávat varianty (pokud na to máte dostatek konverzí). Hezký článek na téma pokrytí všech možností má Andrew Anderson. Jde o to, abyste maximalizovali šanci, že alespoň jedna varianta bude vítězná, a to uděláte jen tak, že budete testovat co nejvíce od sebe hodně odlišných variant.

Mýlit se je cennější, než když máte pravdu. Když máte pravdu, dostanete očekávaný výsledek, ale když se mýlíte, získáte lepší výsledek.

9. Pokud vypadají výsledky příliš dobře, jsou špatně

Za ta léta testování jsem se naučil být (ještě větší) skeptik. Pokud to vypadá příliš dobře, bude v tom někde chyba. Dokonce to má i oficiální název: Twymanův zákon.

Všechny ty případovky, kdy změnou barvy tlačítka vylétla konverze o 253 % atp? Bullshit. Průměrné zlepšení v A/B testu je v nižších jednotkách procent.

10. Nezastavujte variantu v průběhu testu a neměňte poměr návštěvnosti

Vypadá jedna z variant, že je to propadák? Nezastavujte ji. Prosím. Stejně tak neměňte poměr návštěvnosti v průběhu testu.

Protože se vystavujte riziku Simpsonova paradoxu (ne, není to ten seriálový). Radši vám to ukážu na příkladu:

| 1. semestr | 2. semestr | součet | ||||

|---|---|---|---|---|---|---|

| Student A | 2/8 | 25% | 2/2 | 100% | 4/10 | 40% |

| Student B | 1/5 | 20% | 4/5 | 80% | 5/10 | 50% |

Je zřejmé, že student A byl úspěšnější v obou semestrech, avšak celkově byl úspěšnější student B, přičemž celkový počet zkoušek byl pro oba stejný.

Podstata paradoxu spočívá v tom, že B měl poměrně vysokou úspěšnost během 5 zkoušek, tedy dlouhodobě. Student A, který v tomto semestru měl sice úspěšnost 100 %, avšak aplikovanou pouze na dvě zkoušky.

Závěr

Gratuluji, že jste to dočetli až sem. Slibuji, že další článek bude letně odlehčený, ať vám nezavařím mozek.

Zdroje:

https://cxl.com/blog/stopping-ab-tests-how-many-conversions-do-i-need/

https://cxl.com/blog/ab-testing-guide/#how-analyze-ab-tests

https://hookedondata.org/guidelines-for-ab-testing/

https://cxl.com/blog/marketing-experiments/

https://www.alexbirkett.com/ab-testing/

https://netflixtechblog.com/improving-experimentation-efficiency-at-netflix-with-meta-analysis-and-optimal-stopping-d8ec290ae5be

https://www.convertize.com/ab-testing-tools/

https://booking.ai/is-your-a-b-testing-effort-just-chasing-statistical-ghosts-eb85602bef7e

https://www.evanmiller.org/how-not-to-run-an-ab-test.html

Smysluplná debata